前言

论文:https://arxiv.org/pdf/2203.01044.pdf

代码:https://github.com/THUDM/SelfKG

摘要

实体对齐是构建网络规模知识图谱的一个基本问题,旨在识别不同知识图谱中的等价实体。在其发展过程中,标签监督被认为是准确对齐的必要条件。受自监督学习最近进展的启发,探讨了在实体对齐中可以在多大程度上摆脱监督。通常,标签信息(正实体对)用于监督将每个正实体对中的对齐实体拉得更近的过程。然而,论文的理论分析表明,在实际实体对齐的学习中,将未标记的负对推远比将标记的正对拉近受益更多。利用这一发现,为实体对齐制定了自监督学习目标。论文提出SelfKG的有效策略来优化这一目标,以对齐没有标签监督的实体。在基准数据集上的广泛实验表明,无监督的SelfKG可以与最先进的有监督基线相匹配或取得相当的结果。SelfKG的性能表明,自监督学习为知识图谱中的实体对齐提供了巨大的潜力。

挑战

基于表示学习的对齐方法以其优越的灵活性和准确性成为实体对齐的主流解决方案。然而,它们的成功在很大程度上依赖于人工标注提供的监督信息,而对于网络规模的知识图谱来说,这可能是有偏差的,而且获取起来成本非常高。鉴于这一基本挑战,本文旨在探索在没有标签监督的情况下,跨知识图谱对齐实体的潜力。

分析过程

从概念上讲,对于来自两个知识图谱的每个成对实体,现有学习目标是,使相同的实体(即正对)彼此更相似,使不同的实体(即负对)不相似。在嵌入空间中,通过将对齐的实体拉得更近,将不同的实体推得更远来实现这一目标。

在上述实体对齐的过程中,首先,监督信息是为了拉近一致实体的距离。其次,另一个问题是标签感知负对的生成过程。对于知识图谱中的每个实体,在训练中,其负对是通过从其他知识图谱中随机抽样实体形成的,同时排除groundtruth。如果没有监督,隐式对齐的实体很可能被采样为负对,从而破坏训练(即碰撞)。

贡献及解决方案

论文介绍了知识图谱中的自监督实体对齐问题,提出了Self KG框架,不依赖于标记实体对来对齐实体。它由3个技术部分组成:1)相对相似性度量;2)自负采样;3)多负队列。

- 为了摆脱标签监督,从理论上提出了相对相似度度量(relative similarity metric, RSM)的概念,实现自监督学习目标。RSM的核心思想是,它不是直接将对齐的实体在嵌入空间中拉得更近,而是试图将未对齐的负向量推得更远,从而避免使用正向量对的监督。相对而言,在优化RSM时,(隐式)对齐的实体可以被认为是被拖在一起的。

- 为了解决标签感知负采样的监督和无标签感知负采样的假负样本碰撞之间的两难问题,SelfKG进一步提出了自负采样策略,即对于KG中的每个实体,通过直接从同一KG中采样实体来形成其负对。换句话说,SelfKG仅依赖于从输入KG中随机抽样的负实体对。理论上表明,这种策略对于跨知识图谱对齐实体仍然有效。

- 最后,理论分析还表明,随着负样本数量的增加,自监督损失误差项衰减得更快,即大量的负样本有利于SelfKG。然而,实时编码大量负样本的计算成本非常高。本文通过扩展MoCo技术来解决这个问题,以支持两个负队列,两个队列对应于两个对齐的KGs,确保负样本的有效增加。

问题定义

知识图谱可以表示为一组三元组的集合T,每个三元组表示为两个实体??∈?和??∈?之间及它们的关系???∈?。在这篇论文中,将一个知识图谱表示为?={?,?,?},其中?,?和?分别是它的实体集、关系集和三元组集。

对于两个知识图谱,??={??, ??, ?? }和??={??, ??, ?? },存在的实体对的集合定义为?={(??)|?∈??, ?∈??, ?⇔?},其中⇔表示等价。在??和??之间进行实体对齐的目标是,为?y中的每个实体从??中找到等价的实体,如果存在的话。

自监督实体对齐

SelfKG框架

统一空间学习(Uni-space learning)

简单地说,将来自不同知识图谱的实体嵌入到统一空间中可以极大地有利于对齐任务。通过标注的实体对,很自然地利用监督信息将不同的空间对齐为一个。例如,合并对齐的实体进行训练,或学习具有丰富的训练标签的投影矩阵,以将来自不同嵌入空间的实体投影到统一空间。

对于多语言数据集(如DBP15K),该问题更具挑战性。由于预训练语言模型,现在可以使用高质量的多语言初始嵌入。例如,多语言BERT在最近的工作中被使用。在SelfKG中,采用LaBSE——一种在109种不同语言上训练的最先进的多语言预训练语言模型——将不同的知识图谱嵌入到统一空间中。

邻域聚合(Neighborhood aggregator)

为了进一步改善实体嵌入,使用邻域聚合将邻居实体的信息聚合到中心实体。本文直接使用具有一层的单头图注意力网络来聚合一跳邻居的预训练嵌入。

实体对齐问题上很多工作探索了利用多跳图结构。虽然一些研究称它们从多跳邻居中受益,但另一些研究认为单跳邻居在大多数情况下提供了足够的信息。在消融研究中,发现多跳信息实际上损害了SelfKG的性能,这可能是由于在自监督设置中可能不可忽视的远邻噪声。为了证明实体对齐的自监督的最低要求,在聚合过程中只涉及一跳邻居实体。

相对相似度度量(Relative Similarity Metric)

在表示学习中,间隔损失和交叉熵损失被广泛采用作为相似度度量。它们可以表示为噪声对比估计(Noise Contrastive Estimation,NCE)的形式。

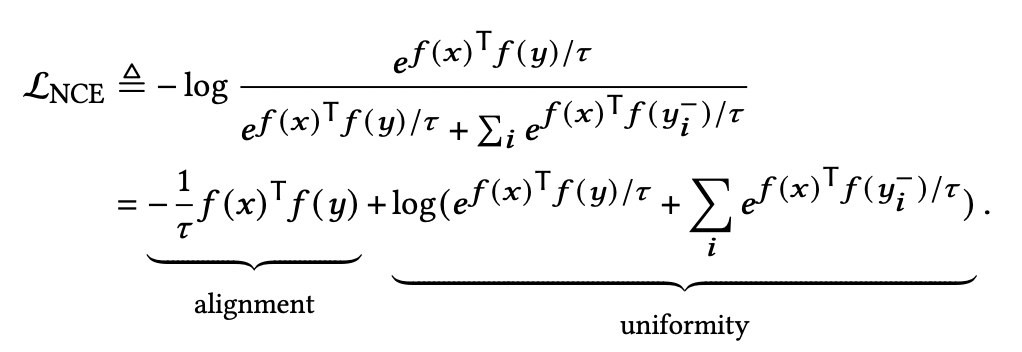

给定一对对齐的实体(x, y),有监督NCE损失为:

其中,f为编码器,满足∥?(·)∥=1。该公式,将- log(1/x),变为logx,再使用log(M/N)=logM-logN。推导出来。

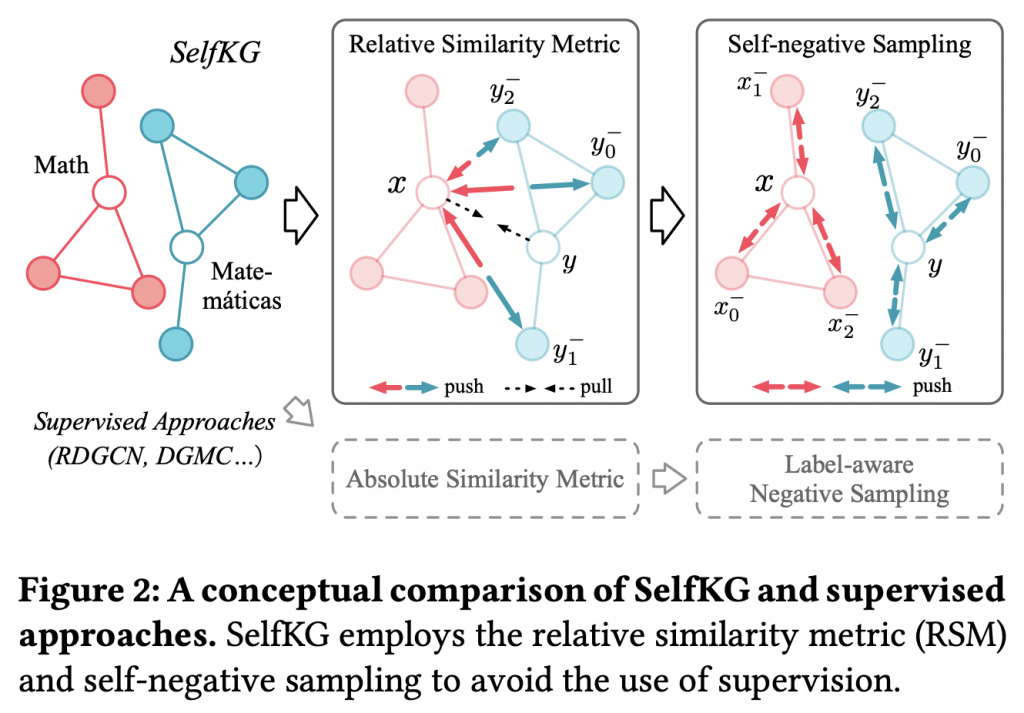

其中“alignment”项是将正的对拉近,而“uniformity”项是将负的对推开。在图2(左)中可以找到知识图谱中的“拉”和“推”实体对的例子。

定理1:对于固定?>0,当负样本数量?→∞时,(归一化)对比损失LNCE(即LASM)收敛到极限,绝对偏差衰减时间为O(?−2/3)。如果一个完全均匀编码器?存在,它形成“uniformity”项的精确最小化。

上式NCE损失成为需要监督信息的绝对相似度度量。然而,尽管知识图谱中实体可能存在歧义和异构性,但对齐的实体对即使不是完全相同的名称,也应具有相似的语义。此外,预训练的词嵌入通过在嵌入空间中投影相似实体来捕获这种语义相似性,从而可以确保方程中相对较大的?(?)??(?),即“alignment”项。

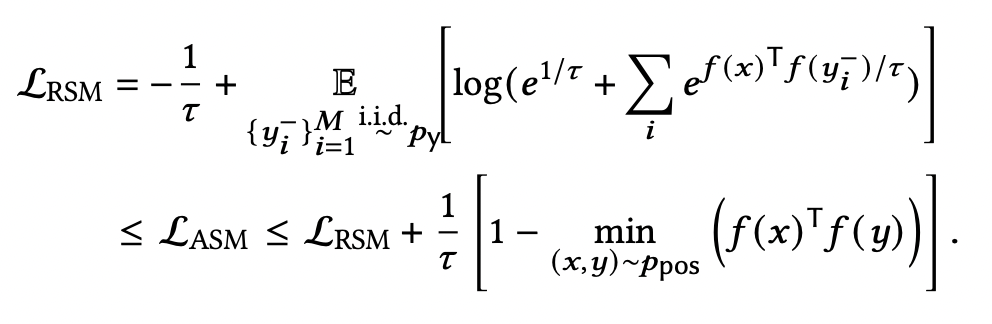

因此,要优化NCE损失,主要任务是优化公式中的“uniformity”项,而不是“alignment”项。考虑到?的有界性质,得到LASM的无监督上界,如下所示:

总是有上式相对相似度度量加上一个由常数控制的绝对偏差作为LASM的上限。通过优化LRSM,通过未对齐的实体被推远,相当于对齐的实体被推近。换句话说,如果不能将对齐的实体拉近(例如,没有正标签),可以将那些未对齐的实体推得足够远。

通过分析实体对齐常用的NCE损失,发现将这些随机采样的(负)对推远比将对齐的(正)对拉近更能使训练受益。因此,在SelfKG中,只专注于试图将负实体对推远,这样就可以摆脱对正实体对(标注的实体对)的使用。

自负采样(Self-Negative Sampling)

实体对齐在没有监督的情况下,SelfKG的重点是抽样负实体对——一个实体来自知识图谱??,另一个实体来自另外的知识图谱??。在负采样过程中,如果没有对标签感知的负采样的监督,底层对齐的实体对很可能被采样为负对,即发生碰撞。通常情况下,如果采样的负数很少,则可以忽略这种碰撞概率;但大量的负样本对SelfKG的成功至关重要,在此情况下,碰撞概率不可忽略。为了缓解这个问题,考虑到??和??具有统一空间,论文建议对实体?∈??从??中提取负样本。通过这样做,可以简单地排除?,即自负采样,从而避免冲突。

然而,可能会因此引起另外两个问题。首先,由于现实世界的数据质量存在噪声,??中可能经常存在多个重复?,这些重复?可能被采样为负值。这也是监督设置面临的挑战,其中一些重复?也可能存在于??中。通过一些证明,表明一定数量的噪声不会影响NCE损失的收敛。

定理2:设平均复制因子?∈N +,?∈R +为常数。噪声ASM表示如下,它仍然收敛到相同的ASM极限,绝对偏差衰减为O(?−2/3)。

第二个问题是,通过将负样本?–?∈??改为?–?∈??,需要确认LRSM是否仍然对实体对齐有效。根据经验,对于选定的负样本?–j∈??,可以预期有一些部分相似的?–?∈??。由于??和??共享编码器?,?(?–?)的优化也将有助于?(?–j)的优化。为了证明这一点,提供以下定理。

定理3:让Ωx,Ωy为知识图谱三元组的空间,分别{?–?: Ωx→R?}??= 1,{?–?: Ωy→R?}??=1随机变量分别服从概率分布??和??,S?−1表示统一的空间。如果存在一个随机变量?:R?→S?−1,使?(?–?)和?(?–?)在S?−1满足相同的分布,1≤?≤?。则有:

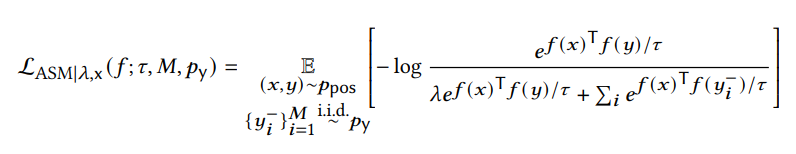

在SelfKG中,统一空间学习条件保证了两个知识图谱的最终统一表示,初始??和??相似但不完全相同,这表明自负采样是必不可少的。然而,随着训练的继续,编码器将得到改进,因为定理2保证使两个知识图谱更对齐。换句话说,??和??的实体嵌入可以看作是来自更大空间中的单个分布的样本,即?? =??。这反过来又使?的存在更容易实现。在实践中,联合优化??和??上的损失,如下所示,图2(右)和图3也说明了这一点。

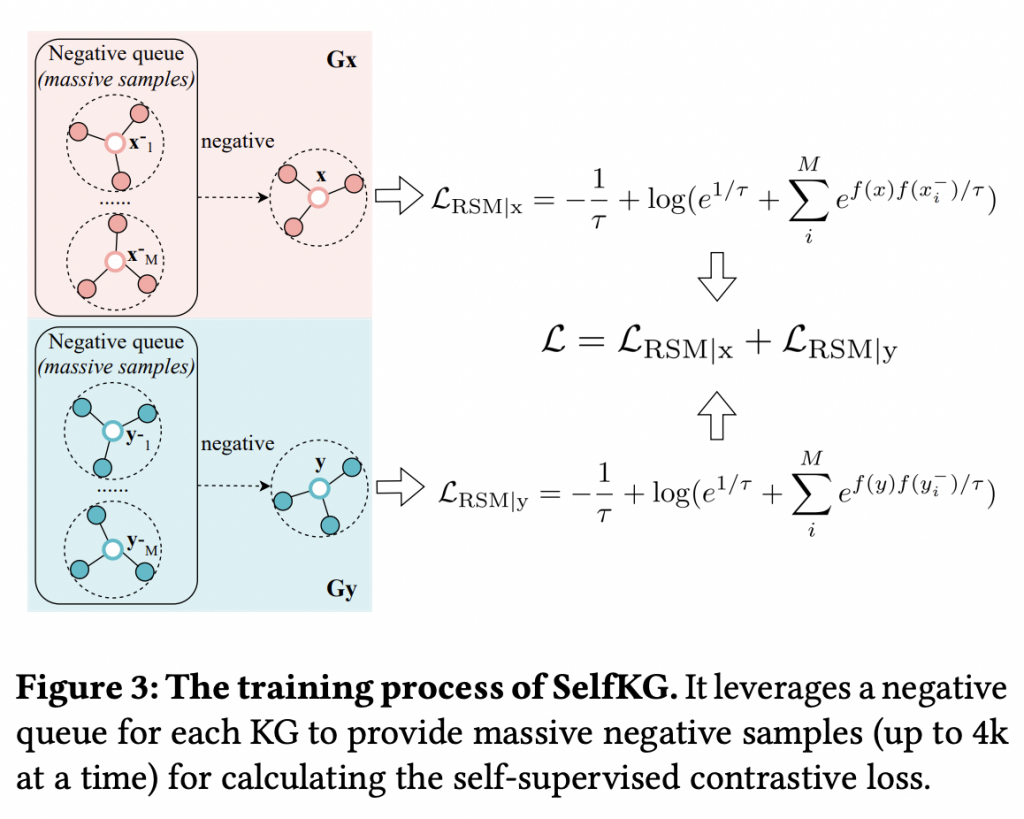

多负队列(Multiple Negative Queues)

增大负样本的数量自然会导致额外的计算成本,因为在运行中编码大量的负样本是计算成非常高。为解决该问题,论文提出将MoCo技术扩展到SelfKG。在MoCo中,维护一个负队列来存储之前编码的batches作为已编码的负样本,该队列以有限的代价存储数千个已编码的负样本。

为了适应SelfKG中的自负采样策略,实际上维护了两个负队列,分别与两个输入知识图谱相关联。图3显示了一个说明性的示例。一开始,不会实现梯度更新,直到其中一个队列达到预定义的长度1+?,其中“1”是当前batch,?是负样本以前batches的数量,|?|是知识图谱中实体的数量,N为batch size。

可以保证不会对当前批次中的实体进行采样。因此,当前批次实际使用的负样本数量为(1 +?)×?−1。

动量更新(Momentum update)

负队列带来的主要挑战是编码样本的过时,特别是那些在训练早期编码的样本,在此期间模型参数会发生巨大变化。因此,只使用一个经常更新的编码器的端到端训练实际上可能会损害训练。为缓解这一问题,采用动量训练策略,维护两个编码器——在线编码器和目标编码器。虽然在线编码器的参数?online通过反向传播即时更新,但用于编码当前批次并将其推入负队列的目标编码器?target则通过动量进行异步更新:

一个合适的动量不仅对稳定的训练很重要,而且还可以通过避免表示崩溃影响最终的表现。

总结

论文提出SelfKG用于自监督实体对齐。图2说明了这一点。相对相似度度量(RSM)将?的非对齐实体推得足够远,而不是直接将底层对齐的?拉到?(标记对)附近,从而实现无标签监督的学习;自负性抽样从??中为?采样负实体,以避免采样真实的?作为其负实体。图3展示了SelfKG的训练。它利用现有的技术——来自预训练语言模型的嵌入和邻域聚合器——来初始化统一空间中的实体嵌入。

论文目标是在不同的知识图谱中对齐具有相同含义的实体。基于得出的三个见解——统一空间学习、相对相似度度量和自负采样,开发了一种自监督实体对齐算法SelfKG,可以在不使用标注数据训练的情况下自动对齐实体。在两个广泛使用的基准数据集DWY100K和DBP15K上的实验表明,SelfKG能够击败或匹配大多数利用训练数据集的监督对齐方法。该发现表明,在实体对齐问题中摆脱监督具有巨大的潜力,希望进行更多的研究,以加深对自监督学习的理解。